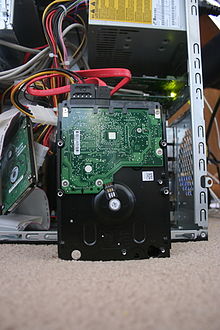

Un disco duro o disco rígido (en inglés Hard Disk Drive, HDD) es un dispositivo no volátil, que conserva la información aún con la pérdida de energía, que emplea un sistema de grabación magnética digital. Dentro de la carcasa hay una serie de platos metálicos apilados girando a gran velocidad. Sobre los platos se sitúan los cabezales encargados de leer o escribir los impulsos magnéticos. Hay distintos estándares para comunicar un disco duro con la computadora; las interfaces más comunes son Integrated Drive Electronics (IDE, también llamado ATA); SCSI generalmente usado en servidores; Serial ATA, este último estandarizado en el año 2004 y FC exclusivo para servidores.

Tal y como sale de fábrica, el disco duro no puede ser utilizado por un sistema operativo. Antes se deben definir en él un formato de bajo nivel, una o más particiones y luego hemos de darles un formato que pueda ser entendido por nuestro sistema.

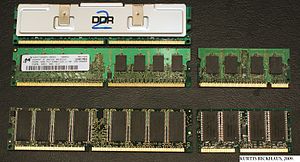

También existe otro tipo de almacenamiento, a efectos prácticos, sustituto del disco duro mecánico, denominadas Unidades de estado sólido que utilizan memorias de circuitos integrados basadas en Flash para almacenar la información. El uso de esta clase de dispositivos generalmente se limitaba a las supercomputadoras, por su elevado precio, aunque hoy en día ya son muchísimo más asequibles para el mercado doméstico.[1] Así, el caché de pista es una memoria de estado sólido, tipo memoria RAM, dentro de una unidad de estado sólido.

Su traducción del inglés es unidad de disco duro, pero este término es raramente utilizado, debido a la practicidad del término de menor extensión disco duro (o disco rígido).

Estructura física

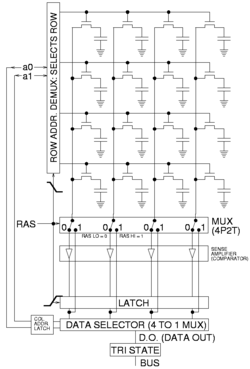

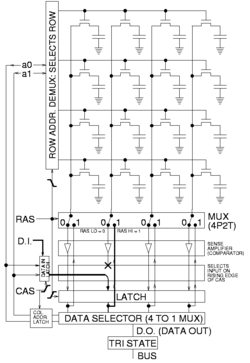

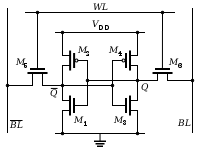

Dentro de un disco duro hay uno o varios platos (entre 2 y 4 normalmente, aunque hay hasta de 6 ó 7 platos), que son discos (de aluminio o cristal) concéntricos y que giran todos a la vez. El cabezal (dispositivo de lectura y escritura) es un conjunto de brazos alineados verticalmente que se mueven hacia dentro o fuera según convenga, todos a la vez. En la punta de dichos brazos están las cabezas de lectura/escritura, que gracias al movimiento del cabezal pueden leer tanto zonas interiores como exteriores del disco.

Cada plato posee dos caras, y es necesaria una cabeza de lectura/escritura para cada cara. Si se observa el esquema Cilindro-Cabeza-Sector de más abajo, a primera vista se ven 4 brazos, uno para cada plato. En realidad, cada uno de los brazos es doble, y contiene 2 cabezas: una para leer la cara superior del plato, y otra para leer la cara inferior. Por tanto, hay 8 cabezas para leer 4 platos, aunque por cuestiones comerciales, no siempre se usan todas las caras de los discos y existen discos duros con un número impar de cabezas, o con cabezas deshabilitadas. Las cabezas de lectura/escritura nunca tocan el disco, sino que pasan muy cerca (hasta a 3 nanómetros), debido a una finísima película de aire que se forma entre éstas y los platos cuando éstos giran (algunos discos incluyen un sistema que impide que los cabezales pasen por encima de los platos hasta que alcancen una velocidad de giro que garantice la formación de esta película). Si alguna de las cabezas llega a tocar una superficie de un plato, causaría muchos daños en él, rayándolo gravemente, debido a lo rápido que giran los platos (uno de 7.200 revoluciones por minuto se mueve a 129 km/h en el borde de un disco de 3,5 pulgadas). Direccionamiento

Cilindro, Cabeza y Sector

Pista (A), Sector (B), Sector de una pista (C), Clúster (D)

Hay varios conceptos para referirse a zonas del disco:

- Plato: cada uno de los discos que hay dentro del disco duro.

- Cara: cada uno de los dos lados de un plato.

- Cabeza: número de cabezales.

- Pista: una circunferencia dentro de una cara; la pista 0 está en el borde exterior.

- Cilindro: conjunto de varias pistas; son todas las circunferencias que están alineadas verticalmente (una de cada cara).

- Sector : cada una de las divisiones de una pista. El tamaño del sector no es fijo, siendo el estándar actual 512 bytes, aunque próximamente serán 4 KB. Antiguamente el número de sectores por pista era fijo, lo cual desaprovechaba el espacio significativamente, ya que en las pistas exteriores pueden almacenarse más sectores que en las interiores. Así, apareció la tecnología ZBR (grabación de bits por zonas) que aumenta el número de sectores en las pistas exteriores, y utiliza más eficientemente el disco duro.

El primer sistema de direccionamiento que se usó fue el CHS (cilindro-cabeza-sector), ya que con estos tres valores se puede situar un dato cualquiera del disco. Más adelante se creó otro sistema más sencillo: LBA (direccionamiento lógico de bloques), que consiste en dividir el disco entero en sectores y asignar a cada uno un único número. Éste es el que actualmente se usa.

Tipos de conexión

Si hablamos de disco duro podemos citar los distintos tipos de conexión que poseen los mismos con la placa base, es decir pueden ser SATA, IDE, SCSI o SAS:

- IDE: Integrated Device Electronics ("Dispositivo con electrónica integrada") o ATA (Advanced Technology Attachment), controla los dispositivos de almacenamiento masivo de datos, como los discos duros y ATAPI (Advanced Technology Attachment Packet Interface) Hasta aproximadamente el 2004, el estándar principal por su versatilidad y asequibilidad. Son planos, anchos y alargados.

- SCSI: Son interfaces preparadas para discos duros de gran capacidad de almacenamiento y velocidad de rotación. Se presentan bajo tres especificaciones: SCSI Estándar (Standard SCSI), SCSI Rápido (Fast SCSI) y SCSI Ancho-Rápido (Fast-Wide SCSI). Su tiempo medio de acceso puede llegar a 7 milisegundos y su velocidad de transmisión secuencial de información puede alcanzar teóricamente los 5 Mbps en los discos SCSI Estándares, los 10 Mbps en los discos SCSI Rápidos y los 20 Mbps en los discos SCSI Anchos-Rápidos (SCSI-2). Un controlador SCSI puede manejar hasta 7 discos duros SCSI (o 7 periféricos SCSI) con conexión tipo margarita (daisy-chain). A diferencia de los discos IDE, pueden trabajar asincrónicamente con relación al microprocesador, lo que posibilita una mayor velocidad de transferencia.

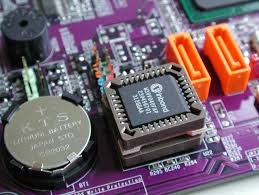

- SATA (Serial ATA): El más novedoso de los estándares de conexión, utiliza un bus serie para la transmisión de datos. Notablemente más rápido y eficiente que IDE. Existen tres versiones, SATA 1 de hasta 1,5 Gigabits por segundo (hoy día descatalogado), SATA 2 de hasta 3 Gigabits por segundo de velocidad de transferencia, el más extendido en la actualidad; y por último SATA 3 de hasta 6 Gigabits por segundo el cual se está empezando a hacer hueco en el mercado. Físicamente es mucho más pequeño y cómodo que los IDE, además de permitir conexión en caliente

- SAS (Serial Attached SCSI): Interfaz de transferencia de datos en serie, sucesor del SCSI paralelo, aunque sigue utilizando comandos SCSI para interaccionar con los dispositivos SAS. Aumenta la velocidad y permite la conexión y desconexión en caliente. Una de las principales características es que aumenta la velocidad de transferencia al aumentar el número de dispositivos conectados, es decir, puede gestionar una tasa de transferencia constante para cada dispositivo conectado, además de terminar con la limitación de 16 dispositivos existente en SCSI, es por ello que se vaticina que la tecnología SAS irá reemplazando a su predecesora SCSI. Además, el conector es el mismo que en la interfaz SATA y permite utilizar estos discos duros, para aplicaciones con menos necesidad de velocidad, ahorrando costes. Por lo tanto, las unidades SATA pueden ser utilizadas por controladoras SAS pero no a la inversa, una controladora SATA no reconoce discos SAS.

Factor de forma

El más temprano "factor de forma" de los discos duros, heredó sus dimensiones de las disqueteras. Pueden ser montados en los mismos chasis y así los discos duros con factor de forma, pasaron a llamarse coloquialmente tipos FDD "floppy-disk drives" (en inglés).

La compatibilidad del "factor de forma" continua siendo de 3½ pulgadas (8,89 cm) incluso después de haber sacado otros tipos de disquetes con unas dimensiones más pequeñas.

- 8 pulgadas: 241,3×117,5×362 mm (9,5×4,624×14,25 pulgadas).

En 1979, Shugart Associates sacó el primer factor de forma compatible con los disco duros, SA1000, teniendo las mismas dimensiones y siendo compatible con la interfaz de 8 pulgadas de las disqueteras. Había dos versiones disponibles, la de la misma altura y la de la mitad (58,7mm). - 5,25 pulgadas: 146,1×41,4×203 mm (5,75×1,63×8 pulgadas). Este factor de forma es el primero usado por los discos duros de Seagate en 1980 con el mismo tamaño y altura máxima de los FDD de 5¼ pulgadas, por ejemplo: 82,5 mm máximo.

Éste es dos veces tan alto como el factor de 8 pulgadas, que comúnmente se usa hoy; por ejemplo: 41,4 mm (1,64 pulgadas). La mayoría de los modelos de unidades ópticas (DVD/CD) de 120 mm usan el tamaño del factor de forma de media altura de 5¼, pero también para discos duros. El modelo Quantum Bigfoot es el último que se usó a finales de los 90'.

- 3,5 pulgadas: 101,6×25,4×146 mm (4×1×5.75 pulgadas).

Este factor de forma es el primero usado por los discos duros de Rodine que tienen el mismo tamaño que las disqueteras de 3½, 41,4 mm de altura. Hoy ha sido en gran parte remplazado por la línea "slim" de 25,4mm (1 pulgada), o "low-profile" que es usado en la mayoría de los discos duros.

- 2,5 pulgadas: 69,85×9,5-15×100 mm (2,75×0,374-0,59×3,945 pulgadas).

Este factor de forma se introdujo por PrairieTek en 1988 y no se corresponde con el tamaño de las lectoras de disquete. Este es frecuentemente usado por los discos duros de los equipos móviles (portátiles, reproductores de música, etc...) y en 2008 fue reemplazado por unidades de 3,5 pulgadas de la clase multiplataforma. Hoy en día la dominante de este factor de forma son las unidades para portátiles de 9,5 mm, pero las unidades de mayor capacidad tienen una altura de 12,5 mm.

- 1,8 pulgadas: 54×8×71 mm.

Este factor de forma se introdujo por Integral Peripherals en 1993 y se involucró con ATA-7 LIF con las dimensiones indicadas y su uso se incrementa en reproductores de audio digital y su subnotebook. La variante original posee de 2GB a 5GB y cabe en una ranura de expansión de tarjeta de ordenador personal. Son usados normalmente en iPods y discos duros basados en MP3.

- 1 pulgadas: 42,8×5×36,4 mm.

Este factor de forma se introdujo en 1999 por IBM y Microdrive, apto para los slots tipo 2 de compact flash, Samsung llama al mismo factor como 1,3 pulgadas.

- 0,85 pulgadas: 24×5×32 mm.

Toshiba anunció este factor de forma el 8 de enero de 2004 para usarse en móviles y aplicaciones similares, incluyendo SD/MMC slot compatible con disco duro optimizado para vídeo y almacenamiento para micromóviles de 4G. Toshiba actualmente vende versiones de 4GB (MK4001MTD) y 8GB (MK8003MTD) 5 y tienen el Record Guinness del disco duro más pequeño.

Los principales fabricantes suspendieron la investigación de nuevos productos para 1 pulgada (1,3 pulgadas) y 0,85 pulgadas en 2007, debido a la caída de precios de las memorias flash, aunque Samsung introdujo en el 2008 con el SpidPoint A1 otra unidad de 1,3 pulgadas.

El nombre de "pulgada" para los factores de forma normalmente no identifica ningún producto actual (son especificadas en milímetros para los factores de forma más recientes), pero estos indican el tamaño relativo del disco, para interés de la continuidad históEstructura lógica

Dentro del disco se encuentran:

Integridad

Debido a la distancia extremadamente pequeña entre los cabezales y la superficie del disco, cualquier contaminación de los cabezales de lectura/escritura o las fuentes puede dar lugar a un accidente en los cabezales, un fallo del disco en el que el cabezal raya la superficie de la fuente, a menudo moliendo la fina película magnética y causando la pérdida de datos. Estos accidentes pueden ser causados por un fallo electrónico, un repentino corte en el suministro eléctrico, golpes físicos, el desgaste, la corrosión o debido a que los cabezales o las fuentes sean de pobre fabricación.

El eje del sistema del disco duro depende de la presión del aire dentro del recinto para sostener los cabezales y su correcta altura mientras el disco gira. Un disco duro requiere un cierto rango de presiones de aire para funcionar correctamente. La conexión al entorno exterior y la presión se produce a través de un pequeño agujero en el recinto (cerca de 0,5 mm de diámetro) normalmente con un filtro en su interior (filtro de respiración, ver abajo). Si la presión del aire es demasiado baja, entonces no hay suficiente impulso para el cabezal, que se acerca demasiado al disco, y se da el riesgo de fallos y pérdidas de datos. Son necesarios discos fabricados especialmente para operaciones de gran altitud, sobre 3.000 m. Hay que tener en cuenta que los aviones modernos tienen una cabina presurizada cuya presión interior equivale normalmente a una altitud de 2.600 m como máximo. Por lo tanto los discos duros ordinarios se pueden usar de manera segura en los vuelos. Los discos modernos incluyen sensores de temperatura y se ajustan a las condiciones del entorno. Los agujeros de ventilación se pueden ver en todos los discos (normalmente tienen una pegatina a su lado que advierte al usuario de no cubrir el agujero. El aire dentro del disco operativo está en constante movimiento siendo barrido por la fricción del plato. Este aire pasa a través de un filtro de recirculación interna para quitar cualquier contaminante que se hubiera quedado de su fabricación, alguna partícula o componente químico que de alguna forma hubiera entrado en el recinto, y cualquier partícula generada en una operación normal. Una humedad muy alta durante un periodo largo puede corroer los cabezales y los platos.

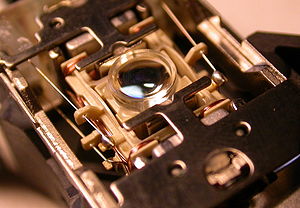

Cabezal de disco duro IBM sobre el plato del disco

Para los cabezales resistentes al magnetismo grandes (GMR) en particular, un incidente minoritario debido a la contaminación (que no se disipa la superficie magnética del disco) llega a dar lugar a un sobrecalentamiento temporal en el cabezal, debido a la fricción con la superficie del disco, y puede hacer que los datos no se puedan leer durante un periodo corto de tiempo hasta que la temperatura del cabezal se estabilice (también conocido como “aspereza térmica”, un problema que en parte puede ser tratado con el filtro electrónico apropiado de la señal de lectura).

Los componentes electrónicos del disco duro controlan el movimiento del accionador y la rotación del disco, y realiza lecturas y escrituras necesitadas por el controlador de disco. El firmware de los discos modernos es capaz de programar lecturas y escrituras de forma eficiente en la superficie de los discos y de reasignar sectores que hayan fallado.Funcionamiento mecánico

Un disco duro suele tener:

- Platos en donde se graban los datos.

- Cabezal de lectura/escritura.

- Motor que hace girar los platos.

- Electroimán que mueve el cabezal.

- Circuito electrónico de control, que incluye: interfaz con la computadora, memoria caché.

- Bolsita desecante (gel de sílice) para evitar la humedad.

- Caja, que ha de proteger de la suciedad, motivo por el cual suele traer algún filtro de aire.

Historia

Antiguo disco duro de

IBM (modelo 62PC, «Piccolo»), de 64,5 MB, fabricado en 1979

Al principio los discos duros eran extraíbles, sin embargo, hoy en día típicamente vienen todos sellados (a excepción de un hueco de ventilación para filtrar e igualar la presión del aire).

El primer disco duro, aparecido en 1956, fue el IBM 350 modelo 1, presentado con la computadora Ramac I: pesaba una tonelada y su capacidad era de 5 MB. Más grande que una nevera actual, este disco duro trabajaba todavía con válvulas de vacío y requería una consola separada para su manejo.

Su gran mérito consistía en el que el tiempo requerido para el acceso era relativamente constante entre algunas posiciones de memoria, a diferencia de las cintas magnéticas, donde para encontrar una información dada, era necesario enrollar y desenrollar los carretes hasta encontrar el dato buscado, teniendo muy diferentes tiempos de acceso para cada posición.

La tecnología inicial aplicada a los discos duros era relativamente simple. Consistía en recubrir con material magnético un disco de metal que era formateado en pistas concéntricas, que luego eran divididas en sectores. El cabezal magnético codificaba información al magnetizar diminutas secciones del disco duro, empleando un código binario de «ceros» y «unos». Los bits o dígitos binarios así grabados pueden permanecer intactos años. Originalmente, cada bit tenía una disposición horizontal en la superficie magnética del disco, pero luego se descubrió cómo registrar la información de una manera más compacta.

El mérito del francés Albert Fert y al alemán Peter Grünberg (ambos premio Nobel de Física por sus contribuciones en el campo del almacenamiento magnético) fue el descubrimiento del fenómeno conocido como magnetorresistencia gigante, que permitió construir cabezales de lectura y grabación más sensibles, y compactar más los bits en la superficie del disco duro. De estos descubrimientos, realizados en forma independiente por estos investigadores, se desprendió un crecimiento espectacular en la capacidad de almacenamiento en los discos duros, que se elevó un 60% anual en la década de 1990.

Estructura lógica de las particiones

Dependiendo del sistema de archivos utilizado en cada partición, su estructura lógica será distinta. En los casos de MS-DOS y Windows 95, está formada por sector de arranque, FAT, copia de la FAT, directorio raíz y área de datos. De todas formas, el sector de arranque es un elemento común a todos los tipos de particiones.

Todas las particiones tienen un sector de arranque (el primero de la partición) con información relativa a la partición. Si la partición tiene instalado un sistema operativo, este sector se encargará de arrancarlo. Si no hubiese ningún sistema operativo (como es el caso de una partición para datos) y se intentara arrancar, mostraría un mensaje de error.

Índice · Publicaciones · Saulo.Net

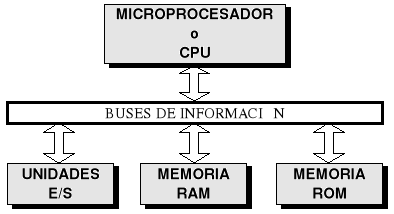

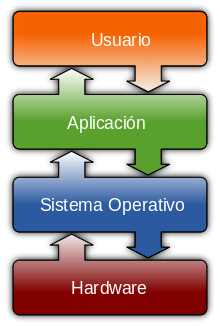

5. Secuencia de arranque de un ordenador

Todos los ordenadores disponen de un pequeño programa almacenado en memoria ROM (Read Only Memory, memoria de sólo lectura), encargado de tomar el control del ordenador en el momento de encenderlo. Lo primero que hace el programa de arranque es un breve chequeo de los componentes hardware. Si todo está en orden, intenta el arranque desde la primera unidad física indicada en la secuencia de arranque. Si el intento es fallido, repite la operación con la segunda unidad de la lista y así hasta que encuentre una unidad arrancable. Si no existiese ninguna, el programa de arranque mostraría una advertencia. Esta secuencia de arranque se define en el programa de configuración del ordenador (también llamado Setup, CMOS o BIOS). Lo usual es acceder a este programa pulsando la tecla Suprimir mientras se chequea la memoria RAM, sin embargo su forma de empleo depende del modelo del ordenador. Por ejemplo, la secuencia A:, C: indica que primero se intentará arrancar desde la disquetera y si no fuera posible, desde el primer disco duro.

Nota: Normalmente los programas de configuración utilizan la siguiente nomenclatura: la unidad A: es la primera unidad de disquete; B:, la segunda; C:, el primer disco duro; y D:, el segundo.

Suponiendo que arrancamos desde el disco duro, el programa de arranque de la ROM cederá el control a su programa de inicialización (Master Boot). Este programa buscará en la tabla de particiones la partición activa y le cederá el control a su sector de arranque.

El programa contenido en el sector de arranque de la partición activa procederá al arranque del sistema operativo.

Algunas aclaraciones: Cuando compramos un disco duro nuevo, éste viene sin particionar. Esto significa que el disco duro no es arrancable y hay que configurarlo desde un disquete (o un CD-ROM). Para ello es necesario establecer la secuencia de arranque de manera que esté la disquetera antes que el disco duro (de lo contrario puede no lograrse el arranque). Por el contrario, si la secuencia de arranque es C:, A: y el disco duro es ya arrancable, no será posible arrancar desde un disquete, ya que ni siquiera lo leerá.

Índice · Publicaciones · Saulo.Net

6. Sistemas de archivos

Un sistema de archivos es una estructura que permite tanto el almacenamiento de información en una partición como su modificación y recuperación. Para que sea posible trabajar en una partición es necesario asignarle previamente un sistema de archivos. Esta operación se denomina dar formato a una partición.

Generalmente cada sistema de archivos ha sido diseñado para obtener el mejor rendimiento con un sistema operativo concreto (FAT para DOS, FAT32 para Windows 98, NTFS para Windows NT, HPFS para OS/2…). Sin embargo, es usual que el mismo sistema operativo sea capaz de reconocer múltiples sistemas de archivos. A continuación se comentan los sistemas de archivos más comunes.

FAT (File Allocate Table, tabla de asignación de archivos)

Este sistema de archivos se basa, como su nombre indica, en una tabla de asignación de archivos o FAT. Esta tabla es el índice del disco. Almacena los grupos utilizados por cada archivo, los grupos libres y los defectuosos. Como consecuencia de la fragmentación de archivos, es corriente que los distintos grupos que contienen un archivo se hallen desperdigados por toda la partición. La FAT es la encargada de seguir el rastro de cada uno de los archivos por la partición.

Grupo .— Un grupo, cluster o unidad de asignación es la unidad mínima de almacenamiento de un archivo en una partición y está formada por uno o varios sectores contiguos del disco. Esto quiere decir que el espacio real ocupado por un archivo en disco será siempre múltiplo del tamaño del grupo. Además, cada grupo puede almacenar información de un solo archivo. Si no cabe en un solo grupo, se utilizarán varios (no necesariamente contiguos). Para hacernos una idea del nefasto resultado de un tamaño de grupo incorrecto, consideremos dos archivos de 1 byte cada uno. Si el tamaño del grupo es de 32 KB, se utilizarán dos grupos y el espacio real ocupado en disco habrá sido de 64 KB = ¡65.536 bytes! en vez de 2 bytes, como sería de esperar.

Este sistema posee importantes limitaciones: nombres de archivos cortos; tamaño máximo de particiones de 2 GB; grupos (clusters) demasiados grades, con el consiguiente desaprovechamiento de espacio en disco; elevada fragmentación, que ralentiza el acceso a los archivos. Pero tiene a su favor su sencillez y compatibilidad con la mayoría de sistemas operativos.

Debido a que la FAT de este sistema de archivos tiene entradas de 16 bits (por eso, a veces se llama FAT16), sólo se pueden utilizar 216 = 65.536 grupos distintos. Esto implica que, con el fin de aprovechar la totalidad del espacio de una partición, los grupos tengan tamaños distintos en función del tamaño de la partición. Por ejemplo, con un grupo de 16 KB se puede almacenar hasta 216 grupos * 16 KB/grupo = 220 KB = 1 GB de información. El límite de la partición (2 GB) se obtiene al considerar un grupo máximo de 32 KB (formado por 64 sectores consecutivos de 512 bytes).

VFAT (Virtual FAT)

Este sistema de archivos logra remediar uno de los mayores problemas del sistema FAT: los nombres de archivos y directorios sólo podían contener 8 caracteres de nombre y 3 de extensión. Con VFAT, se logra ampliar este límite a 255 caracteres entre nombre y extensión.

La mayor ventaja de VFAT es que tiene plena compatibilidad con FAT. Por ejemplo, es factible utilizar la misma partición para dos sistemas operativos que utilicen uno FAT y otro VFAT (MS-DOS y Windows 95). Cuando entremos desde MS-DOS, los nombres largos de archivos se transforman en nombres cortos según unas reglas establecidas, y pueden ser utilizados de la manera habitual. De todas maneras, hay que prestar cierta atención cuando se trabaja desde MS-DOS con archivos que tienen nombres largos: no se deben realizar operaciones de copiado o borrado, ya que se corre el riesgo de perder el nombre largo del archivo y quedarnos sólo con el corto. Desde Windows 95, se trabaja de forma transparente con nombres cortos y largos.

Tanto las particiones FAT como las VFAT están limitadas a un tamaño máximo de 2 GB. Esta es la razón por la que los discos duros mayores de este tamaño que vayan a trabajar con alguno de los dos sistemas, necesiten ser particionados en varias particiones más pequeñas. El sistema de arhivos FAT32 ha sido diseñado para aumentar este límite a 2 TB (1 terabyte = 1024 GB).

FAT32 (FAT de 32 bits)

El sistema FAT32 permite trabajar con particiones mayores de 2 GB. No solamente esto, sino que además el tamaño del grupo (cluster) es mucho menor y no se desperdicia tanto espacio como ocurría en las particiones FAT. La conversión de FAT a FAT32, se puede realizar desde el propio sistema operativo Windows 98, o bien desde utilidades como Partition Magic. Sin embargo, la conversión inversa no es posible desde Windows 98, aunque sí desde Partition Magic.

Hay que tener en cuenta que ni MS-DOS ni las primeras versiones de Windows 95 pueden acceder a los datos almacenados en una partición FAT32. Esto quiere decir que si tenemos en la misma partición instalados MS-DOS y Windows 98, al realizar la conversión a FAT32 perderemos la posibilidad de arrancar en MS-DOS (opción "Versión anterior de MS-DOS" del menú de arranque de Windows 98). Con una conversión inversa se puede recuperar esta opción. Por estos motivos de incompatibilidades, no es conveniente utilizar este sistema de archivos en particiones que contengan datos que deban ser visibles desde otros sistemas de archivos. En los demás casos, suele ser la opción más recomendable.

En la siguiente tabla, se comparan los tamaños de grupo utilizados según el tamaño de la partición y el sistema de archivos empleado:

| Tamaño de la partición | Tamaño del cluster |

| FAT | FAT32 |

| < 128 MB | 2 KB | No soportado |

| 128 MB - 256 MB | 4 KB |

| 256 MB - 512 MB | 8 KB |

| 512 MB - 1 GB | 16 KB | 4 KB |

| 1 GB - 2 GB | 32 KB |

| 2 GB - 8 GB | No soportado |

| 8 GB - 16 GB | 8 KB |

| 16 GB - 32 GB | 16 KB |

| 32 GB - 2 TB | 32 KB |

NTFS (New Technology File System, sistema de archivos de nueva tecnología)

Este es el sistema de archivos que permite utilizar todas las características de seguridad y protección de archivos de Windows NT. NTFS sólo es recomendable para particiones superiores a 400 MB, ya que las estructuras del sistema consumen gran cantidad de espacio. NTFS permite definir el tamaño del grupo (cluster), a partir de 512 bytes (tamaño de un sector) de forma independiente al tamaño de la partición.

Las técnicas utilizadas para evitar la fragmentación y el menor desaprovechamiento del disco, hacen de este sistema de archivos el sistema ideal para las particiones de gran tamaño requeridas en grandes ordenadores y servidores.

HPFS (High Performance File System, sistema de archivos de alto rendimiento)

HPFS es el sistema de archivos propio de OS/2. Utiliza una estructura muy eficiente para organizar los datos en las particiones.

HPFS no utiliza grupos sino directamente sectores del disco (que equivalen a un grupo de 512 bytes). En vez de utilizar una tabla FAT al principio de la partición, emplea unas bandas distribuidas eficazmente por toda la partición. De esta forma se consigue, suprimir el elevado número de movimientos que los cabezales de lectura/escritura tienen que realizar a la tabla de asignación en una partición FAT. El resultado de este sistema es una mayor velocidad de acceso y un menor desaprovechamiento del espacio en disco.

MS-DOS (y Windows 3.1) reconoce únicamente particiones FAT; Windows 95 admite tanto particiones FAT como VFAT; Windows 98 y Windows 95 OSR2 soportan FAT, VFAT y FAT32; Windows NT 4.0 admite particiones FAT, VFAT y NTFS; el futuro Windows 2000 dará soporte a las particiones FAT, VFAT, FAT32 y NTFS; Linux admite su propio sistema de archivos y, dependiendo de las versiones, la mayoría de los anteriores.

Índice · Publicaciones · Saulo.Net

7. Arranque específico de cada sistema operativo

MS-DOS, Windows 95 y Windows 98

Los sistemas operativos MS-DOS y Windows 9x, necesitan arrancar desde una partición primaria ubicada en la primera unidad física de disco duro. Además, la instalación de estos sistemas operativos en particiones que comiencen después de los primeros 528 MB del disco duro, puede impedir que arranquen. Según lo anterior, el lugar para situar la partición se ve reducida a los primeros 528 MB del primer disco duro. Este límite imposibilita entonces la instalación de varios sistemas operativos basados en FAT en particiones mayores de este tamaño. De todas maneras, algunos gestores de arranque (o la propia BIOS del ordenador) son capaces de cambiar la asignación de discos duros de forma que el primero sea el segundo y el segundo, el primero: en este caso particular sí sería posible arrancar una partición FAT desde una segunda unidad física.

Windows NT

Windows NT puede arrancar desde cualquier disco duro, ya sea desde una partición primaria o desde una partición lógica. Sin embargo, en el caso de que se instale en una partición lógica o en un disco duro distinto al primero, es necesario que el gestor de arranque de Windows NT se instale en una partición primaria del primer disco duro. Si tenemos ya instalado otro sistema operativo MS-DOS o Windows 9x, Windows NT instalará su gestor de arranque en el sector de arranque de la partición del anterior sistema operativo. Este gestor de arranque permitirá arrancar tanto el anterior sistema operativo como Windows NT (ya esté en una partición lógica o en otro disco duro).

Linux

Linux, al igual que Windows NT, puede instalarse en una partición primaria o en una partición lógica, en cualquiera de los discos duros. Si la instalación no se realiza en una partición primaria del primer disco duro, es necesario instalar un gestor de arranque. Linux proporciona un potente (aunque poco intuitivo) gestor de arranque llamado LILO. Las posibilidades de instalación son dos: instalarlo en la partición de Linux o en el sector de arranque del disco duro (Master Boot Record). La primera opción es preferible si Linux se instala en una partición primaria del primer disco duro (debe ser la partición activa) junto a otro sistema operativo. Para el resto de los casos, no queda más remedio que instalarlo en el Master Boot del primer disco duro. Desde aquí es capaz de redirigir el arranque incluso a una partición lógica (que, como sabemos, no se pueden activar) que contenga Linux. Nótese que, en este caso, si borramos la partición de Linux el gestor de arranque

LILO seguirá apareciendo (ya que está antes de acceder a cualquier partición). La única manera de desinstalarlo si no podemos hacerlo desde el propio Linux, consiste en restaurar el sector de arranque original. Esto se puede lograr desde MS-DOS con la orden indocumentada FDISK /MBR.

Otra advertencia más: algunas distribuciones de Linux (como Red Hat) no respetan el espacio libre de una partición extendida. Esto significa que hay que tener cuidado de no solapar una partición primaria de Linux con espacio libre de la partición extendida.

En todos los casos anteriores, cuando se habla de instalar un sistema operativo en una partición primaria se asume que ésta tiene que estar activada a no ser que se utilice un gestor de arranque. En este caso, si el gestor de arranque se instala en una partición, ésta deberá activarse; pero si se instala en el sector de arranque del disco duro, la partición activa será indiferente.

Índice · Publicaciones · Saulo.Net

8. Consejos a la hora de crear particiones

¿Qué partición elegir?

La principal decisión que debemos tomar a la hora de crear una partición es elegir entre primaria o lógica. Recordemos que las particiones lógicas deben ser creadas dentro de una partición primaria especial denominada partición extendida. Ya hemos visto que la mejor política que podemos seguir es utilizar, en la medida de lo posible, antes las particiones lógicas que las primarias: podemos crear un número indefinido de particiones lógicas pero sólo cuatro particiones primarias (contando la extendida).

Las particiones primarias suelen ser el lugar ideal para instalar sistemas operativos, ya que son las únicas que se pueden activar. Los sistemas operativos MS-DOS, Windows 95 y Windows 98 sólo pueden ser instalados en particiones primarias. Y aunque Windows NT, Linux y OS/2 puedan ser instalados en particiones lógicas, puede que ésta no sea siempre la opción más acertada. La razón es que es necesario instalar algún gestor de arranque, ya sea en el sector de arranque del disco duro o en el de alguna partición primaria. Si no deseamos alterar ninguna de las particiones primarias existentes ni el sector de arranque, la única opción es realizar una instalación en una partición primaria del primer disco duro.

¿Dónde situar la partición?

Debido a que MS-DOS y Windows 9x presentan problemas al instalarse detrás de los primeros 528 MB del disco duro, es preferible crear sus particiones al principio del disco duro (o lo antes posible, sin superar este límite). Los demás sistemas operativos, en caso de haberlos, se instalarán entonces a continuación. Generalmente suele ser más acertado instalar los sistemas operativos en el primer disco duro. Sin embargo, debido a la flexibilidad de Linux o Windows NT podemos inclinarnos por otras opciones dependiendo de la configuración actual de nuestro equipo.

¿Cuántas particiones crear?

Algunos usuarios prefieren separar los sistemas operativos, programas y datos en sus correspondientes particiones. Esto puede aportar una mayor robustez al sistema, ya que la corrupción de los archivos del sistema operativo o los programas no afectan a los datos. Además, si utilizamos particiones separadas para los sistemas operativos y los programas, nos facilita la utilización de los mismos programas desde distintos sistemas operativos. Por ejemplo, una partición lógica FAT para programas permitiría ejecutar los mismos programas desde Windows NT (instalado en una partición NTFS) o desde Windows 98 (instalado en una partición FAT32). Pero esta disposición del disco duro aumenta su complejidad (un mayor número de unidades) y obliga a calcular a priori el tamaño de cada partición. Como ya dijimos anteriormente, las únicas particiones que deben ser primarias son las de los sistemas operativos, el resto serán lógicas.

Una opción intermedia consiste en separar los archivos del sistema (sistema operativo y programas) de nuestros datos. De esta manera, no se utilizan tantas unidades aunque sí se ofrece una mayor seguridad y organización para nuestros datos.

¿De qué tamaño?

Nos quedan por comentar las razones de eficiencia que nos pueden llevar a crear nuevas particiones. Para evitar desperdiciar el menor espacio posible con particiones FAT o VFAT, conviene que tengan un tamaño lo menor posible (recordemos que el tamaño del grupo depende del tamaño de la partición). Sin embargo, el aumento del número de particiones, aunque sea más eficiente, hace más complejo nuestro sistema. Debemos buscar entonces un compromiso entre el número de particiones creadas y el tamaño del grupo (cluster) empleado en cada una de ellas.

Veamos unos ejemplos (en todos ellos suponemos que deseamos trabajar únicamente en Windows 95 con particiones FAT): si tenemos un disco duro de 2,5 GB y, ya que el máximo de una partición FAT es 2 GB, es más eficiente crear una de 1 GB (grupo de 16 KB) y otra de 1,5 GB (grupo de 32 KB) que dos de 1,25 GB (grupo de 32 KB); si tenemos un disco duro de 3 GB, es igualmente más eficiente una de 1 GB (16 KB) y otra de 2 GB (32 KB) que dos de 1,5 GB (32 KB), aunque en razones de eficiencia sería mucho mejor 3 de 1 GB (16 KB); por último, si tenemos un poco más de 1 GB libre en el disco duro es preferible crear una partición que utilice un grupo de 16 KB, aunque quede espacio sin particionar, que una de 32 KB que ocupe la totalidad del espacio, ya que a la larga el desaprovechamiento sería mayor.

Problemas con las letras de unidades: orden de las particiones

Cuando se realizan cambios en las particiones, hay que considerar los posibles efectos que esto puede desencadenar en la asignación de letras de unidades. Los sistemas operativos MS-DOS y Windows 9x utilizan la letra C para la unidad del sistema operativo. Al resto de unidades visibles se les asigna letra en el siguiente orden: particiones primarias detrás de la actual, particiones primarias de los siguientes discos duros, particiones lógicas de la unidad actual, particiones lógicas de los siguientes discos duros, particiones primarias anteriores a la actual y, por último, el resto de unidades físicas (como la unidad lectora de CD-ROM).

Unidades visibles.— Son las unidades que se pueden ver desde un sistema operativo, es decir, aquellas que utilizan un sistema de archivos reconocido por el sistema operativo. Las particiones con un sistema de archivos incompatible con el sistema operativo no son accesibles (es como si no existiesen).

La única letra que se puede cambiar manualmente es la del CD-ROM, el resto de letras son asignadas automáticamente sin posibilidad de cambio. En ocasiones es preferible asignar una letra alta (por ejemplo la R) a la unidad de CD-ROM ya que así no se ve afectada por los posibles cambios de configuración en las particiones.

Para cambiar la letra del CD-ROM en MS-DOS es necesario modificar la línea del AUTOXEC.BAT que contenga la orden MSCDEX y añadir al final el modificador /L:unidad, donde unidad es la letra que deseamos asignar. Si no hay suficientes letras de unidades disponibles (por defecto sólo están permitidas hasta la D), es necesario añadir la siguiente línea al CONFIG.SYS: LASTDRIVE=Z. En este caso, se han definido todas las letras posibles de unidades (hasta la Z).

En Windows 95 o Windows 98, elegimos Sistema del Panel de Control; seleccionamos la segunda ficha (Administrador de dispositivos); hacemos clic en el signo más a la izquierda de CD-ROM; hacemos doble clic sobre nuestra unidad de CD-ROM; y, finalmente, en el campo Letra de la primera unidad de la ficha Configuración, seleccionamos la letra que deseamos asignar a la unidad de CD-ROM.

Windows NT, permite la asignación dinámica de letras de unidad mediante el Administrador de discos. En Windows NT, la primera letra de unidad es la primera partición primaria del primer disco duro, por lo que puede ocurrir que la propia partición de Windows NT no sea la C.

Linux carece de estos problemas ya que no trabaja con letras de unidad sino con discos duros físicos (hda, hdb, hdc y hdd) y particiones según el lugar que ocupan en la tabla de particiones (hda1, hda2, hda3…).

Para evitar que las mismas particiones tengan asignadas distintas letras conviene colocar primero las particiones reconocidas por más sistemas operativos (FAT) y por último las más específicas (como NTFS o la de Linux).

Índice · Publicaciones · Saulo.Net

9. Trabajar con varios sistemas operativos

Si instalamos varios sistemas operativos en el mismo ordenador, debemos tener una manera eficiente de arrancar con cada uno de ellos. Una posibilidad poco acertada consiste en activar cada vez la partición que queremos arrancar en la próxima sesión con el ordenador. La otra posibilidad es instalar un gestor de arranque que aparezca antes de cargar algún sistema operativo.

Los gestores de arranque suelen ofrecer un menú con los distintos sistemas operativos instalados para que el usuario elija uno de ellos cada vez que encienda el ordenador. Es frecuente que tengan alguna opción predeterminada y un contador de tiempo. Si en un tiempo establecido no se elige ninguna opción, se carga automáticamente el sistema operativo predeterminado.

El gestor de arranque suministrado con Windows NT 4.0 se suele instalar en una partición MS-DOS o Windows 9x, y sólo permite elegir entre esta partición y la de Windows NT.

LILO, el gestor de arranque de Linux, puede instalarse tanto en el sector de arranque del disco duro como en la partición de Linux. Reconoce la mayoría de los sistemas operativos instalados en el ordenador y puede, incluso, arrancar sistemas operativos MS-DOS o Windows 9x desde un segundo disco duro. El mayor inconveniente es su poco amistoso modo de empleo. Al cargarse aparece un mensaje (LILO Boot) pidiéndonos el nombre del sistema operativo. Es necesario escribirlo y pulsar Enter. La tecla Tabulador permite ver las opciones posibles y Enter activa la opción predeterminada.

Otros gestores de arranque, como el de IBM (suministrado con Partition Magic 3.0), necesitan una partición primaria del primer disco duro exclusivamente para ellos. Lógicamente, ésta debe ser la partición activa. El gestor de arranque de IBM tiene una interfaz de usuario cómoda, aunque también algunas limitaciones: tiene problemas para arrancar sistemas operativos desde una unidad de disco duro diferente a la primera, ocupa una de las cuatro particiones primarias posibles del primer disco duro, y no es capaz de arrancar una partición primaria FAT32 (Windows 98) si existen en el disco duro otras particiones primarias FAT32 o FAT (como MS-DOS).

Cuando se trabaja con varios sistemas operativos conviene elegir correctamente los sistemas de archivos de cada partición, con el fin de intercambiar y compartir datos entre los sistemas instalados.

En 1992, los discos duros de 3,5 pulgadas alojaban 250 Megabytes, mientras que 10 años después habían superado 40 Gigabytes (40000 Megabytes). En la actualidad, ya contamos en el uso cotidiano con discos duros de más de 2 terabytes (TB), (2000000 Megabytes)

En 2005 los primeros teléfonos móviles que incluían discos duros fueron presentados por Samsung y Nokia, aunque no tuvieron mucho éxito ya que las memorias flash los acabaron desplazando, sobre todo por asuntos de fragilidad.Características de un disco duro

Las características que se deben tener en cuenta en un disco duro son:

- Tiempo medio de acceso: Tiempo medio que tarda la aguja en situarse en la pista y el sector deseado; es la suma del Tiempo medio de búsqueda (situarse en la pista), Tiempo de lectura/escritura y la Latencia media (situarse en el sector).

- Tiempo medio de búsqueda: Tiempo medio que tarda la aguja en situarse en la pista deseada; es la mitad del tiempo empleado por la aguja en ir desde la pista más periférica hasta la más central del disco.

- Tiempo de lectura/escritura: Tiempo medio que tarda el disco en leer o escribir nueva información: Depende de la cantidad de información que se quiere leer o escribir, el tamaño de bloque, el número de cabezales, el tiempo por vuelta y la cantidad de sectores por pista.

- Latencia media: Tiempo medio que tarda la aguja en situarse en el sector deseado; es la mitad del tiempo empleado en una rotación completa del disco.

- Velocidad de rotación: Revoluciones por minuto de los platos. A mayor velocidad de rotación, menor latencia media.

- Tasa de transferencia: Velocidad a la que puede transferir la información a la computadora una vez la aguja está situada en la pista y sector correctos. Puede ser velocidad sostenida o de pico.

Otras características son:

Presente y futuro

Actualmente la nueva generación de discos duros utiliza la tecnología de grabación perpendicular (PMR), la cual permite mayor densidad de almacenamiento. También existen discos llamados "Ecológicos" (GP - Green Power), los cuales hacen un uso más eficiente de la energía.

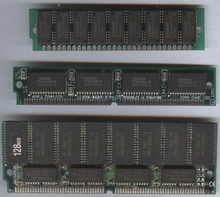

Unidades de Estado sólido

Las unidades de estado sólido son dispositivos electrónicos, construidos únicamente con chips de memoria flash, por ello, no son discos, pero juegan el mismo papel a efectos prácticos con todas las mejoras que ello conlleva.

Se viene empezando a observar que las Unidades de estado sólido es posible que terminen sustituyendo al disco duro por completo a largo plazo.

Son muy rápidos ya que no tienen partes móviles y consumen menos energía. Todos esto les hace muy fiables y físicamente casi indestructibles. Sin embargo su costo por GB es aún muy elevado ya que el coste de un disco duro común de 500 GB es equivalente a un SSD de 32 GB, 40 € aproximadamente.

Los discos que no son discos: Las Unidades de estado sólido han sido categorizadas repetidas veces como "discos", cuando es totalmente incorrecto denominarlas así, puesto que a diferencia de sus predecesores, sus datos no se almacenan sobre superficies cilíndricas ni platos. Esta confusión conlleva habitualmente a creer que "SSD" significa Solid State Disk, en vez de Solid State Drive

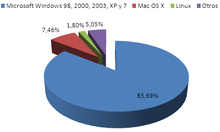

Fabricantes

Los recursos tecnológicos y el saber hacer requeridos para el desarrollo y la producción de discos modernos implica que desde 2007, más del 98% de los discos duros del mundo son fabricados por un conjunto de grandes empresas: Seagate (que ahora es propietaria de Maxtor), Western Digital, Samsung e Hitachi (que es propietaria de la antigua división de fabricación de discos de IBM). Fujitsu sigue haciendo discos portátiles y discos de servidores, pero dejó de hacer discos para ordenadores de escritorio en 2001, y el resto lo vendió a Western Digital. Toshiba es uno de los principales fabricantes de discos duros para portátiles de 2,5 pulgadas y 1,8 pulgadas. ExcelStor es un pequeño fabricante de discos duros.

Decenas de ex-fabricantes de discos duros han terminado con sus empresas fusionadas o han cerrado sus divisiones de discos duros, a medida que la capacidad de los dispositivos y la demanda de los productos aumentó, los beneficios eran menores y el mercado sufrió un significativa consolidación a finales de los 80 y finales de los 90. La primera víctima en el mercado de los PC fue Computer Memories Inc.; después de un incidente con 20 MB defectuosos en discos en 1985, la reputación de CMI nunca se recuperó, y salieron del mercado de los discos duros en 1987. Otro notable fracaso fue el de MiniScribe, quien quebró en 1990: después se descubrió que tenía en marcha un fraude e inflaba el número de ventas durante varios años. Otras muchas pequeñas compañías (como Kalok, Microscience, LaPine, Areal, Priam y PrairieTek) tampoco sobrevivieron a la expulsión, y habían desaparecido para 1993; Micropolis fue capaz de aguantar hasta 1997, y JTS, un recién llegado a escena, duró sólo unos años y desapareció hacia 1999, aunque después intentó fabricar discos duros en India. Su vuelta a la fama se debió a la creación de un nuevo formato de tamaño de 3” para portátiles. Quantum e Integral también investigaron el formato de 3”, pero finalmente se dieron por vencidos. Rodime fue también un importante fabricante durante la década de los 80, pero dejó de hacer discos en la década de los 90 en medio de la reestructuración y ahora se concentra en la tecnología de la concesión de licencias; tienen varias patentes relacionadas con el formato de 3,5“.

- 1988: Tandon vendió su división de fabricación de discos duros a Western Digital, que era un renombrado diseñador de controladores.

- 1989: Seagate compró el negocio de discos de alta calidad de Control Data, como parte del abandono de Control Data en la creación de hardware.

- 1990: Maxtor compró MiniScribe que estaba en bancarrota, haciéndolo el núcleo de su división de discos de gama baja.

- 1994: Quantum compró la división de almacenamiento de Digital Equipment otorgando al usuario una gama de discos de alta calidad llamada ProDrive, igual que la gama tape drive de Digital Linear Tape

- 1995: Conner Peripherals, que fue fundada por uno de los cofundadores de Seagate junto con personal de MiniScribe, anunciaron un fusión con Seagate, la cual se completó a principios de 1996.

- 1996: JTS se fusionó con Atari, permitiendo a JTS llevar a producción su gama de discos. Atari fue vendida a Hasbro en 1998, mientras que JTS sufrió una bancarrota en 1999.

- 2000: Quantum vendió su división de discos a Maxtor para concentrarse en las unidades de cintas y los equipos de respaldo.

- 2003: Siguiendo la controversia en los fallos masivos en su modelo Deskstar 75GXP , pioneer IBM vendió la mayor parte de su división de discos a Hitachi, renombrándose como Hitachi Global Storage Technologies, Hitachi GST.

- 2003: Western Digital compró Read-Rite Corp., quien producía los cabezales utilizados en los discos duros, por 95,4 millones de dólares en metálico.

- 2005: Seagate y Maxtor anuncian un acuerdo bajo el que Seagate adquiriría todo el stock de Maxtor. Esta adquisición

dispositivos por canal.

dispositivos por canal.

SATA

SATA

En los primeros tiempos de la informática personal, que podemos suponer se inicia con la introducción del PC ("Personal Computer") por IBM a mediados de 1981 [

En los primeros tiempos de la informática personal, que podemos suponer se inicia con la introducción del PC ("Personal Computer") por IBM a mediados de 1981 [